Quelle LLM est utilisée par narratheque.io

Cette question revient de plus en plus souvent, et c’est légitime puisque les modèles évoluent très rapidement. Au point qu’il est compliqué de choisir et même de savoir quel module est le plus approprié pour nos usages.

Narratheque 2.0 est multi-LLM

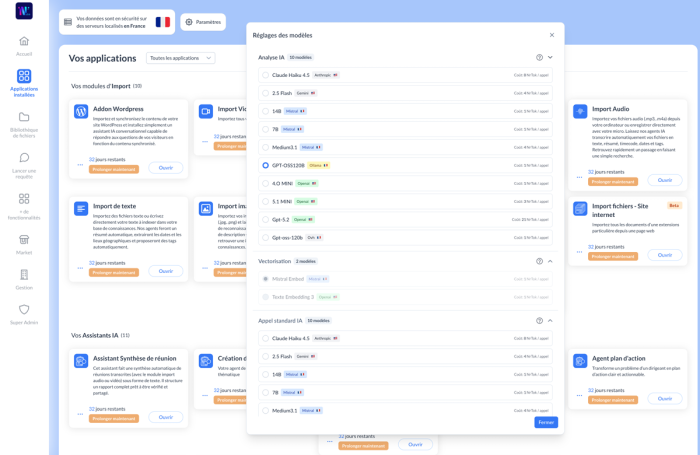

La V.2 de narratheque.io permet désormais de choisir finement quelle IA vous souhaitez utiliser, en fonction de chaque étape du processus (analyse, vectorisation, requêtes, transcription, websearch, etc…). Ce choix se paramètre sur chaque Base de Connaissances, et se déclenche aussi au niveau de la fenêtre des requêtes, vous offrant de tester les réponses de différentes LLM dans une même conversation.

Le choix ne se fait pas uniquement quand vous faites une requête, mais également à chaque étape du processus. Le processus de la plateforme est découpé de la manière suivante:

- Analyse IA : Quand vous déposez un fichier, ce dernier est analysé par la LLM choisie pour générer le résumé, identifier les dates, génerer les tags ainsi que les points géolocalisés.

- Vectorisation : La vectorisation consiste à transformer les contenus en valeurs numériques afin que l’IA puisse retrouver automatiquement les informations les plus pertinentes avant de générer une réponse.

Requête bibliothèque : Chaque appel, question qui est fait sur la bibliothèque (ou Base de Connaissances) est envoyé à la LLM de votre choix pour formuler une réponse.

Description image : Au dépôt d’une image, c’est la LLM choisie qui va analyser le contenu pour en rédiger une description détaillée.

Requête externe : LLM utilisée si vous souhaitez faire une requête hors de votre bibliothèque. Seules les éléments de votre requête est envoyé à la LLM.

Recherche web par LLM : LLM utilisée si vous souhaitez faire une requête avec recherche web hors de votre bibliothèque. Seules les éléments de votre requête est envoyé à la LLM.

Génération images : LLM choisie pour générer des images à partir de votre requête

Description audio : LLM choisie pour générer la transcription de vos fichiers audios et vidéos

Les LLM actuellement disponibles dans narratheque sont :

Claude Haiku 4.5 d’Anthropic (US)

2.5 Flash de Gemini (US)

14B / 7B et Medium 3.1 de Mistral (FR)

GPT-OSS120B depuis Ollama (FR) ou OVH (FR/CA)

4.O MINI d’Openai (US)

5.1 MINI d’Openai (US)

Gpt-5.2 d’Openai (US)

Qwen2.5 sur serveur OVH (FR/CA)

Gemini 3.0 Pro (Nano Banana) de Google (US)

Nova-2 et 3 de Deepgram (US)

Whisper-large-v3 sur serveur OVH (FR/CA)

Ces modèles sont amenés à évoluer et être mis à jour régulièrement. Ils sont sollicités à chaque requête et peuvent donc être changés en temps réel, par un simple clic. Les données vectorisées sont quant à elles stockées sur des serveurs dédiés, installés dans le pays de la plateforme (en France et au Québec pour le moment).

L’abonnement à narratheque offre l’accès à toutes ces LLM, sans coûts supplémentaires, mise à part la consommation des token, variable en fonction des LLM elles-mêmes.

Nous testons et mettons régulièrement à disposition de nos utilisateurs de nouvelles LLM, nous sommes bien évidemment capables de vous installer des LLM sur mesure, en fonction de vos besoins en matière de sécurité et de confidentialité.